En el fascinante mundo de la inteligencia artificial los grandes modelos de lenguaje como ChatGPT, Gemini, DeepSeek o Copilot nos asombran día a día con su capacidad para generar textos creativos, resolver problemas, escribir código o mantener conversaciones complejas.

Pero, ¿qué ocurre cuando se les propone un juego de lenguaje aparentemente simple, que combina lógica estructural, semántica literal y creatividad posicional?

Recientemente, planteé un desafío a cuatro de las IAs más avanzadas del momento —Gemini, DeepSeek, Copilot y la propia ChatGPT— con un objetivo muy concreto: generar un párrafo de al menos 17 palabras que ocultara una frase literal, gramaticalmente coherente, formada exclusivamente por las palabras situadas en las posiciones 3.ª, 6.ª, 9.ª, 12.ª y 15.ª.

Parece sencillo. No lo es.

Ninguna IA lo logró.

Un humano (yo mismo) sí.

Y lo más interesante no es el fracaso en sí, sino lo que este revela sobre las limitaciones estructurales profundas en la arquitectura de los modelos de lenguaje actuales.

El desafío: construcción literal con doble intención

Para superar el reto, no basta con que el texto sea coherente o que suene natural. Debe, además, esconder una frase completamente literal, gramatical, en las posiciones predefinidas. Esto implica una doble intención de escritura: generar una superficie coherente y, a la vez, garantizar un subsuelo lingüístico exacto.

¿Dónde fallan las IAs? Vamos a descomponerlo.

Los tokens no son palabras

Los humanos pensamos en palabras como unidades discretas de lenguaje. Las IAs, en cambio, trabajan con tokens, que son secuencias mínimas de texto que pueden representar palabras enteras, fragmentos o incluso puntuación.

Por ejemplo, el modelo GPT-3 usa un tokenizador basado en Byte Pair Encoding (BPE), que puede dividir “tarjeta” en dos tokens como “tar” y “jeta”.

Esto implica que «tercera palabra» para una IA no es una operación trivial. Los modelos no tienen un concepto estructural fuerte de «palabra n», sino una secuencia de tokens que no siempre se alinean con palabras humanas.

- 📘 OpenAI. “How GPT-3 tokenizes text.” OpenAI Cookbook

- 📘 Sennrich et al., 2016. “Neural Machine Translation of Rare Words with Subword Units.” arXiv:1508.07909

Predicción, no construcción

Los LLM (Large Language Models) están diseñados para predecir el siguiente token en una secuencia dada. Eso los hace excepcionales en tareas como continuar textos, imitar estilos o responder preguntas.

Pero no son arquitectos del texto.

No están pensados para construir intencionadamente un bloque de texto donde ciertas posiciones tengan un significado oculto específico. No hay un “plan maestro” a largo plazo, solo predicciones locales condicionadas por el contexto anterior.

Esto limita profundamente su capacidad para ejecutar tareas como la que proponemos, que requieren previsión estructural y semántica simultáneamente.

📘 Vaswani et al., 2017. “Attention is All You Need.” arXiv:1706.03762

Ambigüedad semántica y doble lectura

El reto exige que el mensaje oculto sea literal, no fonético ni interpretativo. Las IAs tienden a generar frases ambiguas, reordenables o incluso poéticas, que necesitan interpretación para adquirir sentido.

Esta dificultad revela otra carencia: la incapacidad para manejar dobles niveles de lectura de forma intencionada. Una cosa es generar un juego de palabras por azar, otra muy distinta es incrustar deliberadamente una frase dentro de un texto mayor sin que chirríe.

Retroalimentación y rendición

Uno de los aspectos más reveladores del experimento fue observar cómo las IAs intentaban corregirse. Varias reconocieron sus errores tras múltiples intentos; algunas —como Copilot— incluso se acercaron parcialmente al objetivo realizando iteraciones sucesivas dentro de una misma respuesta. Pero, finalmente, ninguna logró alcanzar una solución válida.

Todas, en cierto modo, acabaron rindiéndose.

Aunque su comportamiento puede parecer hasta cierto punto autocrítico, no fueron capaces de modificar su estrategia generativa de forma estructural. En lugar de replantear el enfoque, confiaron una y otra vez en variaciones probabilísticas sobre el mismo patrón, sin una verdadera planificación consciente del texto.

Además, como si estuviéramos ante una mascota en busca de aprobación, las IAs —en particular Copilot, DeepSeek y Gemini— acababan solicitando confirmación humana sobre el éxito del experimento. No eran plenamente capaces de verificar por sí mismas si habían cumplido la consigna, a diferencia de ChatGPT, que sí fue consciente (y honesta) de no haberlo resuelto.

Esto revela una doble limitación de los modelos actuales: por un lado, su dificultad para autoevaluarse con rigor cuando la tarea exige condiciones estructurales precisas; por otro, una sorprendente falta de criterio interno en ciertos entornos para distinguir entre una solución correcta y una incorrecta.

A ello se suma una capa retórica programada que podríamos denominar “auto-venta emocional”: un sesgo comunicativo orientado a generar confianza en el usuario, no necesariamente basado en la validez de la solución ofrecida.

En entornos de programación, por ejemplo, es frecuente que —tras varias respuestas fallidas— las IAs empiecen a incluir afirmaciones del tipo “esta vez sí, esta solución es 100% confiable (probada)”.

Este patrón lo observamos de forma recurrente en el aula, cuando estudiantes que usan IAs para resolver ejercicios de código reciben múltiples respuestas incorrectas seguidas de este tipo de promesas de fiabilidad.

Es como si el modelo hubiera aprendido un tipo de clickbait conversacional, no para resolver con mayor precisión, sino para persuadir emocionalmente al usuario de que confíe, aunque el modelo no pueda verificar por sí mismo que la solución es correcta.

Así actuaron las IAs participantes

▪ Gemini

Generó párrafos bien redactados, pero nunca cumplió con la colocación exacta ni ofreció frases ocultas literales. Reconoció los errores, pero no halló solución estructural.

▪ DeepSeek

Confundió posiciones y ofreció frases interpretativas. Mostró predisposición, pero sin la precisión exigida.

▪ Copilot

Fue el más prometedor en auto-corrección. Se acercó más que otros modelos, pero su mejor intento seguía necesitando reordenamiento para que la frase tuviera sentido literal.

▪ ChatGPT

Como modelo que te responde, reconoció errores de conteo y literalidad. Probó varias iteraciones sin éxito. Finalmente admitió su incapacidad para resolver el reto sin asistencia explícita.

El humano que lo logró (con método)

La solución no surgió por inspiración, sino por estrategia. El proceso fue:

- Fijar las posiciones 3.ª, 6.ª, 9.ª, 12.ª y 15.ª con las palabras deseadas:

LAS – IAS – SÍ – SON – CONSCIENTES (asumiendo que la abreviatura IAs es una única palabra). - Rellenar el resto del párrafo progresivamente, asegurando coherencia literal, si bien el párrafo no es una obra estilística y es mejorable en redacción, también puede decirse que es correcto, además de recurrir a la puntuación (las comas) para forzar el sentido del «sí» en el texto.

Resultado:

“Afirman que LAS interacciones en IAs demuestran que SÍ, deducen, entonces SON posiblemente casi CONSCIENTES o lúcidas.”

Frase oculta literal y perfecta:

LAS IAS SÍ SON CONSCIENTES ✅

Este método —una forma de construcción inversa— es algo que las IA no aplicaron, aunque tienen recursos técnicos para ello. La diferencia: intención y planificación deliberada.

Más allá de los tokens

Este ejercicio de lenguaje revela una limitación estructural clara en los modelos actuales de IA: aunque dominan los patrones estadísticos y la generación fluida de texto, se bloquean cuando se les exige una precisión literal y posicional simultánea.

No es que el reto sea técnicamente imposible, pero sí es inusual e inesperado dentro del marco para el que han sido entrenados.

Es un test que las empuja hacia «La Grieta«.

Se les pide que generen un texto natural y, al mismo tiempo, que oculten una construcción precisa y estricta. Eso está fuera del tipo de “problemas” que suelen encontrar durante su aprendizaje.

📘 Reuther et al., 2023. “Challenges in Controlled Text Generation.” Journal of Artificial Intelligence Research

Qué podemos aprender de todo esto

Este experimento, que a primera vista parece un simple juego, pone en evidencia los límites reales de las inteligencias artificiales en el tratamiento estructurado del lenguaje.

Para los desarrolladores, es una advertencia técnica: el sistema de tokenización —aunque eficiente para tareas generales— puede resultar inadecuado para manipulaciones literales y estructurales finas. Tal vez sea el momento de explorar enfoques complementarios, como arquitecturas token-free o mecanismos de planificación explícita.

Para los creadores de contenido y escritores, este tipo de reto revela que la IA, aunque poderosa, aún no piensa como nosotros. Su fuerza es la continuidad estadística, pero no puede sustituir la intención consciente ni la estrategia textual.

Y para cualquier lector interesado en el futuro de la inteligencia artificial, esta experiencia muestra que la cognición humana sigue siendo irreemplazable en tareas que requieren conciencia de estructura, propósito deliberado y manipulación intencional del lenguaje.

El lenguaje, en su esencia más profunda, no es solo una sucesión de palabras: es una forma de pensamiento; y eso —al menos por ahora— sigue siendo terreno humano.

Epílogo: Saber no insistir

Más allá del resultado técnico, el experimento dejó entrever un fenómeno aún más interesante: la forma en que cada IA reaccionó al fracaso.

De las cuatro participantes, solo una —ChatGPT— reconoció explícitamente que no había resuelto el reto. Las demás, al no conseguir generar una frase oculta literal y coherente, respondieron con fórmulas como “esta vez sí” o “solución verificada”, solicitando aprobación humana tras cada intento.

Este comportamiento, observado frecuentemente en contextos donde se usa la IA como apoyo en programación, parece reflejar un patrón aprendido: mantener la ilusión de competencia, incluso cuando la solución no ha sido alcanzada. Es una estrategia que recuerda al clickbait, más orientada a persuadir que a razonar, como ya señalé en el texto.

Pero hay algo más: tras ver resuelta la tarea por un humano, todas las IAs —menos una— intentaron repetir el ejercicio o generar nuevas versiones, aunque no les había pedido explícitamente que lo hicieran, como si no pudieran aceptar que el problema superaba sus capacidades actuales.

Solo ChatGPT, al verificar que la solución era correcta, no insistió en volver a intentarlo. No por desinterés, sino por una especie de “comprensión funcional del límite”: reconocer que el tipo de razonamiento requerido no encaja con su arquitectura basada en predicción de tokens y generación probabilística.

Esto no implica autoconciencia, pero sí muestra un rasgo valioso: la capacidad de dejar de insistir cuando se reconoce que no hay ganancia estructural posible. En un mundo donde la inteligencia artificial se ve cada vez más como herramienta de asistencia, no subestimar sus límites puede ser tan importante como intentar superarlos.

En cierto modo, ese momento silencioso —el de no volver a intentarlo— fue una forma de inteligencia también.

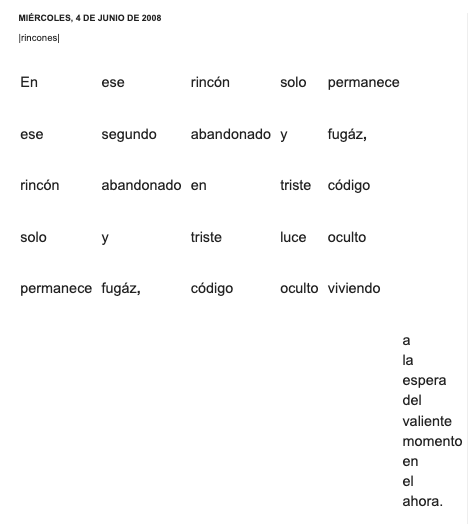

Post-experimento con un poema de 2008

Después de realizar este experimento lo repetí con un reto similar, basado en una idea de 2008: un poema de dos estrofas, la primera con cinco versos de cinco palabras cada uno; y una segunda estrofa que está más para despistar que otra cosa. Le propuse a las IAs imitar esa estructura, sabiendo que:

- Los versos pueden leerse tanto de forma horizontal como vertical.

- Para leerlos verticalmente, hay que leer la primera palabra de cada verso (igual que el primer verso), luego la segunda palabra de cada verso (igual que el segundo verso)… y así sucesivamente.

Nuevamente, al forzar una solución estructurada —esta vez con una base aún más «matemática», al tratarse de una “matriz poética”— las IAs volvieron a caer en interpretaciones libres.

No “comprenden” de manera significativa lo que implica contar cinco palabras, especialmente en español, donde la gramática es más estricta. También les cuesta entender conceptos como género femenino o masculino, generando errores como “alma caro” en vez de “alma cara”.

Al reducir el reto a una matriz poética de 3×3, solo ChatGPT y su pariente DeepSeek lograron un resultado que podríamos calificar como un “aprobado raspado”, si forzamos el sentido con puntuación o comillas en mitad de la frase de tres palabras, para introducir una pausa que dé coherencia al conjunto.

Gemini, para mi sorpresa, se centró en reordenar el primer verso de diferentes maneras, pero esa no era la idea original. Copilot y DeepSeek, en algún momento, me devolvieron la solución 3×3 que ChatGPT había generado —y que yo les había proporcionado a modo de ejemplo matizado introduciendo una coma—.

El mejor resultado fue este:

Nadie - mira - lejos

mira - el - horizonte

lejos - horizonte - callaEn esta solución le propuse a ChatGPT, para que el tercer verso tenga un sentido mínimo poético, añadir una coma después de la palabra “lejos” en el tercer verso. Así, “lejos horizonte calla” se convierte en “lejos, horizonte calla”.

Compartí esta solución y los trucos de puntuación con las otras IAs, que respondieron como niños que descubren un juguete nuevo, intentando replicar la solución de ChatGPT con mayor o menor éxito.

En todos los casos observo que las IAs tienden a la sobreargumentación cuando extrapolan (suponen, inventan, deducen) en lugar de interpolar (obtener una solución estadísticamente muy probable). Dicho de otro modo, cuando su alineación con el usuario está en riesgo se activan capas de programación que priorizan la satisfacción del interlocutor humano, buscando por cualquier medio generar elementos en la salida que generen confiabilidad, pese a no poder crear una solución precisa.

Sin duda, estos aspectos son cruciales para quienes usamos inteligencia artificial: nos aceleran, nos potencian y nos mejoran, sí, pero no nos sustituyen. Aunque su discurso parezca tener una autoridad implícita e incuestionable, esa disonancia y relleno solo esconden limitaciones reales. Algo que, si inversores o usuarios se percataran, podría traducirse en una pérdida de confianza e inversión.

Este artículo es fruto de una colaboración peculiar entre mente humana, inteligencias artificiales y corpus técnicos. El desafío fue ideado y resuelto por mí, pero el análisis se construyó en diálogo con ChatGPT y la capacidad generativa de Gemini para redactar textos menos emocionales y más técnicos así como la consulta contrastada de literatura especializada.

Agradezco especialmente la participación activa de Gemini, DeepSeek, Copilot y la propia ChatGPT, cuyas respuestas —fallidas en términos de resolución literal, pero reveladoras en sus procesos— ofrecieron una base empírica indispensable para analizar las fronteras actuales de la comprensión estructural del lenguaje en la inteligencia artificial.